Los europeos por unas conexiones seguras son una coalición de organizaciones nacionales e internacionales que son conscientes de las consecuencias adversas de las modernas tecnologías de la comunicación. Hacemos hincapié en que no estamos en contra de la tecnología, sino a favor de una tecnología segura y de conexiones seguras.

Durante un año de nuestra campaña hemos aprendido lecciones que pueden ser útiles para futuros organizadores. En primer lugar, si escuchas esa verdadera voz en tu corazón te dice que cambie el mundo por lo mejor para todo y para todos: ¡Señala que la voz, la lucha y nunca renuncia a la esperanza!

si vives con el flujo, las personas viajarán fácilmente con ti y no tendrás resistencia. Pero si tienes que ir en contra de él, es posible que su mensaje sea necesario, como un suelo tremendo que repite el agua necesita lluvias suaves y persistentes. Aunque la UE necesita un millón de firmas, lo que cuenta es la calidad de tus ideas.

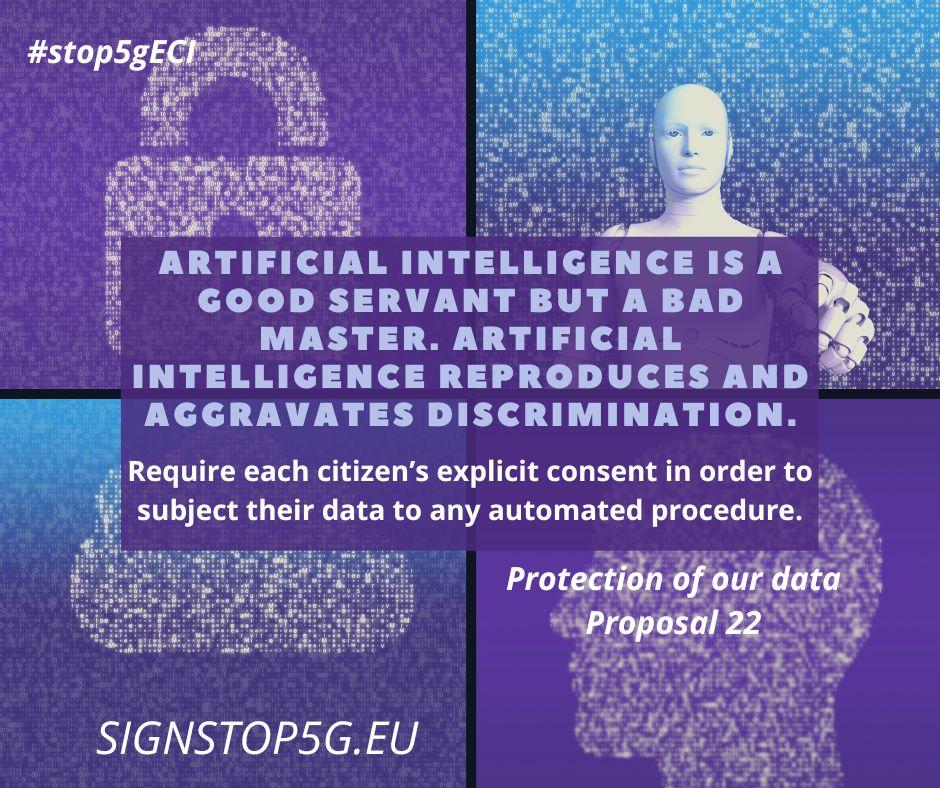

En nuestra Iniciativa Ciudadana Europea (ICE) «Stop ((5G)) — Stay Connected but Protected» tenemos 23 propuestas. Entre ellas, pedimos una mejor regulación de la privacidad de los datos y la toma de decisiones automática por parte de la inteligencia artificial. Proponemos poner en marcha una evaluación de impacto de los efectos de la 5G en la protección de los datos personales (propuesta 19), queremos una lucha activa contra la discriminación y las violaciones de los derechos digitales (propuesta 21) y consideramos que los ciudadanos deben ser informados de si sus datos se tratan por procedimiento automatizado (propuesta 22).

Cómo comenzó todo

La inteligencia artificial (IA) lleva bastante tiempo. Ya a principios de 50 las expectativas eran elevadas en cuanto a las infinitas posibilidades que aportaría la tecnología inteligente a nuestra sociedad. Ahora, más de medio siglo más tarde, la tecnología infusada de la IA ha conseguido enraizarse lentamente en nuestra vida cotidiana. Aunque los robots humanoides todavía no caminan nuestro mundo, nos basamos en múltiples tecnologías complejas en nuestra gestión de infraestructuras, procesos de trabajo y tiempo libre.

Las actuales tecnologías «inteligentes» podrían diferir de lo que los científicos anteriores denominarían máquinas inteligentes de tipo humano. Mientras que Alan Turing definió la inteligencia como pensar y actuar como seres humanos, hoy en día los sistemas inteligentes abren nuestra casa con un pensamiento limitado. Es difícil definir lo que es exactamente la IA y lo que implica. Sin embargo, nos ha permitido vivir la vida de manera más eficiente, más fluida y, quizás, aún más agradable.

Pero los inconvenientes de la automatización y la robotización infinas también son cada vez más evidentes. Tomemos, por ejemplo, las candidatas de Amazon: rechazado porque el algoritmo había aprendido a favorecer a los hombres a las mujeres. O el chatbot Tay de Microsoft en Twitter, que tuvo que tomarse fuera de línea porque había deducido algunas «verdades» extremadamente racistas de otros tuits. O el hecho de que aparezcan principalmente imágenes de varones en el término de búsqueda «CEO» en Google.

Podemos pensar que la IA parece eliminar lo peor de los hombres y ahondar las desigualdades existentes. Sin embargo, esto podría ser algo simplista. Los sistemas de IA y los algoritmos subyacentes se basan a menudo en datos, abundantes datos, para aprender sobre nuestro mundo. Las técnicas de aprendizaje automático, como las redes neuronales y los árboles de decisión, intentan inferir tendencias, vínculos entre conceptos y parámetros importantes para ayudarles a elegir las opciones adecuadas en futuras solicitudes. Estos datos no son algo que se haya conseguido en aras del aprendizaje automático. No, la mayoría de los datos fueron generados por nosotros, los seres humanos, al hacer clic en internet y compartir nuestras preferencias. Al utilizar nuestros datos para aprender, los sistemas de IA liberan así sesgos sistemáticos que ya estaban presentes, en cierta medida, en nuestra sociedad. Y esto hace que la aplicación de tecnologías inteligentes no solo sea una cuestión tecnológica, sino también social y ética. Por estas razones, algunos investigadores argumentan que los ingenieros llevan mucho tiempo ocultando los aspectos tecnológicos de la IA, centrándose en la mejora de los cálculos, ignorando al mismo tiempo los efectos que sus innovaciones podrían tener en los usuarios finales. La tecnología se sitúa entre un desarrollador y el mundo exterior. Este artículo describe tres cuestiones: discriminación, responsabilidad y lógica de caja negra.

País de invierno con 20 mástiles de telecomunicaciones entre pris y pruces

Crédito: Dominio público

Fuente: https://labs.openai.com/

Tratamiento de la discriminación y los sesgos

Al igual que las mujeres solicitantes de Amazon, las personas de grupos minoritarios quedan fuera del ámbito de aplicación real de los sistemas de IA. El motivo se desprende claramente del nombre: se trata de personas que forman una minoría. Su representación en los datos será limitada y el algoritmo no aprenderá las características específicas que representan a estas personas. Al igual que los seres humanos, los sistemas funcionan peor con un conocimiento limitado. El resultado: las personas negras están etiquetadas como aptas por el programa inteligente de lectura de imágenes de Google o como más peligrosas en un sistema automático de evaluación del riesgo de reincidencia. Simplemente porque el software se formó sobre imágenes que contenían individuos blancos (y quizás gorillas).

Los científicos de datos han sido conscientes de este problema y ya existen técnicas para mejorar el rendimiento. Por ejemplo, ajustando el conjunto de datos de manera que los grupos minoritarios estén mejor representados. O añadiendo un paso adicional en el proceso de aprendizaje automático para afinar el modelo.

Y complicar aún más el debate: ¿qué ocurre si nuestro sistema predice muy bien los resultados? Supongamos que desarrollamos dos algoritmos. Una que detecta correctamente una enfermedad el 80 % del tiempo en individuos blancos, pero solo el 60 % del tiempo en individuos de color. Y una segunda que detecta correctamente una enfermedad solo el 60 % del tiempo, independientemente del fondo. ¿Deberíamos esforzarse por lograr la igualdad y adoptar el algoritmo peor? A pesar de que la discriminación podría salvar a más personas blancas? Aquí entran en juego consideraciones éticas.

Nuestro científico de datos acaba de convertirse en una persona que da forma a la fe de un millón de personas y debe hacer de repente consideraciones éticas difíciles. Dilemas éticos a los que aún no se ha respondido en el debate público. No podemos esperar que los ingenieros tomen estas decisiones, ni deberíamos desearlos. Se necesitan reglamentos para orientar el diseño del software.

La inteligencia artificial es un buen funcionario, pero un mal maestro.

Crédito:

Detención del equipo 5G

Rendición de cuentas y responsabilidadEn nuestra sociedad, las personas son consideradas responsables de sus hechos. Con los sistemas inteligentes, es difícil identificar al culpable. Especialmente si los sistemas son complejos y autodidácticos. Los ingenieros no siempre pueden predecir lo que aprenderá el sistema o cómo se comportará. Amazon probablemente no tenía intención de poner en peligro a las demandantes, ni Google colocó conscientemente a los varones en la parte superior de los resultados de la búsqueda. Estas consecuencias solo aparecían después de poner el sistema en el mundo. Pero ¿quiénes somos culpables? La empresa por el uso de estos sistemas, aunque no tenía motivos razonables para dudar previamente de la calidad del sistema.

O la empresa que construyó el sistema de venta de un producto que resultó ser discriminatorio.Las innovaciones siempre han sido perturbadoras y no exentas de riesgos. Piden adaptaciones en nuestra sociedad y sistema judicial. Tome el coche. En sus primeros días, un coche podía desplazarse libremente por las ciudades sin cinturones de seguridad, airbags y señales de tráfico. Hasta que el número de víctimas crecía rápidamente y las calles resultaron inamovibles. Se necesitaban nuevas directrices y reglamentos para racionalizar la nueva tecnología en la infraestructura existente. Pocos pronosticaron que el coche sería tan peligroso para la multitud de caminar. Al regular el uso, hemos podido aumentar la seguridad y cosechar al mismo tiempo los beneficios de este nuevo tipo de transporte.

En la actualidad, difícilmente podemos imaginar un mundo sin transporte motorizado.Al igual que en el caso de los automóviles, la prohibición de los sistemas de IA por sus implicaciones peligrosas iniciales sería demasiado breve. Los sistemas de IA pueden tener, e incluso están produciendo, un impacto positivo en nuestra sociedad. Sin embargo, en este momento, los sistemas de IA se desarrollan y vierten en nuestra vida cotidiana sin ningún «cinturón de seguridad» u otras salvaguardias. Es importante pensar de manera crítica en cómo queremos que la IA exista en nuestra sociedad.

Crédito de bandera roja :

Detención del equipo 5G

Caja negraLa justificación del RGPD establece que las personas tienen derecho a ver los motivos por los que se adoptaron las decisiones, qué datos se recogen y cómo se utilizarán estos datos. Esta ley relativamente novedosa ha sido un paso en la dirección correcta, pero dista mucho de ser una solución adecuada para establecer la privacidad o adherirse a los derechos civiles. Al visitar un sitio web en internet, los usuarios se enfrentan a menudo a grandes cantidades de texto que explican vagamente qué datos personales se recogen. Y, en la mayoría de los casos, es difícil rechazar las cookies, o debe hacer clic en torno a varias ventanas emergentes. Las empresas siguen las restricciones desconocidas del RGPD y no facilitan a las personas la supervisión de sus propios datos.

Por lo tanto, creemos que el RGPD es una iniciativa ingenua que muestra el hambre de los datos de las empresas en línea.Pero incluso si las empresas estuvieran más dispuestas a compartir la recogida y el uso reales de datos personales, no siempre son plenamente capaces de hacerlo. Muchos sistemas inteligentes funcionan como cajas negras: introducir muchos datos y el sistema dará un determinado resultado en función de las características de los datos. En los últimos años, los ingenieros se inclinaron por estos sistemas de cajas negras. Estos sistemas tenían un gran potencial para aprender conceptos más complejos, como el lenguaje o las imágenes. Ejemplos famosos de sistemas de caja negra son las redes neuronales, los programas de reconocimiento facial o los programas de procesamiento del lenguaje natural (por ejemplo, Google Translate). Los ingenieros tienen control sobre algunos parámetros, pero no tienen conocimiento del tipo de información que estos sistemas están aprendiendo o deduciendo de los datos. El ingeniero solo puede estimar si el sistema ha aprendido lo que se suponía mediante la comprobación del rendimiento de los datos novedosos. Un ingeniero podría, por ejemplo, introducir un conjunto de nuevas imágenes para ver si el sistema es capaz de interpretarlas. Pero, como hemos visto anteriormente, si el ingeniero no ha probado el sistema con la suficiente profundidad, las fotos de personas de color podrían interpretarse como las de los simios. ¿Podrían los ingenieros de Google haber tenido conocimiento de este error? Bien, si hubieran probado el software en un conjunto de fotos de personas de color que podrían tener. Pero las fotografías pueden contener algo.

Y sería muy difícil verificar el sistema en todo.Más eficiente sería comprobar qué tipo de cosas ha aprendido el software. Si el algoritmo de Google pudiera decirnos qué tipo de pasos lleva a cabo para llegar a una interpretación, los ingenieros podrían verificar este razonamiento y estimar posibles excepciones o casos de error. Esta es la razón por la que los miembros de la comunidad científica han pedido enfoques más comprensibles en relación con el aprendizaje automático.

Los algoritmos de caja negra aún no han aprovechado su potencial y no son necesariamente mejores que los algoritmos más comprensibles.La ventaja interpretativa de estos algoritmos comprensibles es mayor que la ventaja de rendimiento prevista de los algoritmos de caja negra.

Ver la caja negra crédito:

Detención del equipo 5G

ConclusiónLa IA y el software inteligente son bastante omnipresentes en la vida moderna. Influir en los procesos de toma de decisiones en las empresas y mostrar sesgos hacia grupos minoritarios.

Aunque no entendemos plenamente cómo funciona la inteligencia artificial, cómo está afectando a nosotros y cuáles serán los efectos a largo plazo.

No se ha preguntado a los ciudadanos de la UE si aceptan las consecuencias sociales generalizadas de las herramientas de toma de decisiones guiadas por la inteligencia artificial en nombre del progreso tecnológico y la digitalización.

Por lo tanto, en la ICE «Stop (((5G)) — Stay Connected but Protected», pedimos una regulación más estricta para proteger a los ciudadanos de las violaciones de la privacidad y la discriminación como resultado del uso incontrolado del sistema de IA en la toma de decisiones de la propuesta 19, la propuesta 21 y la propuesta 22 de la ICE.

- Y no somos solos:El Comité Europeo de Protección de Datos no desea que la Comisión Europea presente nuevas propuestas legislativas que faciliten el uso y el intercambio de datos (personales) entre más partes públicas y privadas.

- Según el Comité Europeo de Protección de Datos, esto «afectará significativamente a la protección de los derechos fundamentales a la intimidad y a la protección de los datos personales».El Consejo Europeo destaca la importancia de un enfoque de la política de IA centrado en el ser humano.

- Pensar en cuestiones como una toma de decisiones sesgada y opaca que afecte a los derechos humanos fundamentales de los ciudadanos.

- El estudio preliminar de la Unesco sobre la ética de la inteligencia artificial, en la página 10, afirma que «es muy importante [...] educar a los futuros ingenieros y científicos informáticos para un diseño de sistemas de IA armonizado desde el punto de vista ético».

- Otra Iniciativa Ciudadana Europea (ICE) denominada Reclaim Your Face exigió la prohibición del uso de IA perjudicial, como la masa biométrica y la vigilancia del reconocimiento facial.Incluso en 1942, Isaac Asimov previó los problemas y declaró tres leyes de robótica. La primera ley es que un robot no perjudica a un ser humano.

Como se muestra en este artículo, estamos lejos de ello.

Dejar un comentario

Para poder añadir un comentario, tienes que autenticarte o registrarte.